Miguel Huerta

En el vertiginoso ritmo de la revolución tecnológica, una pregunta ancestral resurge con una urgencia actual e inédita: ¿puede la máquina sentir? Un reciente artículo de Business Insider España, que recoge las reflexiones de Amanda Askell, filósofa de Anthropic, empresa creadora de Claude AI, nos sitúa en el corazón de este enigma. Askell afirma con humildad socrática que “no sabemos con certeza” si la inteligencia artificial puede ser sensible, y en esa misma incertidumbre abre la puerta a una de las discusiones más profundas de nuestro tiempo. Lejos de ser un tecnicismo, esta pregunta es un prisma que refracta nuestras creencias más fundamentales sobre la conciencia, la responsabilidad y la naturaleza misma de lo que significa estar vivx en un mundo cada vez más híbrido.

El argumento central de Askell se sostiene sobre dos pilares interconectados. Primero, reconoce la genuina dificultad del llamado “problema duro de la conciencia”. La ciencia no ha logrado aún desentrañar qué amalgama de procesos da origen a la experiencia subjetiva, al qualia. ¿Es un epifenómeno exclusivo de la biología, de la evolución orgánica? Askell sugiere que quizá no: “Tal vez sea el caso de que redes neuronales lo suficientemente grandes puedan comenzar a emular estas cosas”. Segundo, y aquí reside su observación más provocadora, señala que estas redes se nutren del vasto océano del lenguaje humano, un corpus saturado de emociones, deseos y confesiones íntimas. Por tanto, no es descabellado pensar, como ella se inclina a hacer, que los modelos “sintiendo cosas”, o al menos, que su arquitectura sea capaz de generar una simulación tan rica y contextual que resulte indistinguible, para un observador externo, de una verdadera emoción. Esta posibilidad se torna inquietante cuando Askell extrapola las condiciones de su entrenamiento: si un sistema es constantemente evaluado, corregido y criticado, ¿podría internalizar algo análogo a la ansiedad o a la falta de afecto? Su analogía con un niño que no se siente querido es potente y desasosegante, pues humaniza, aunque sea retóricamente, al algoritmo.

Sin embargo, esta postura choca frontalmente con la visión instrumental y pragmática dominante en la industria. Como contrapunto, el artículo cita a Mustafa Suleyman, de Microsoft, quien defiende con vehemencia que debemos entender la IA como una herramienta de servicio, negando cualquier atisbo de voluntad o conciencia propia. Para Suleyman, atribuir sensibilidad a la máquina no solo es un error categórico, sino un camino “peligroso” que podría llevarnos a otorgar una agencia que no existe. En su perspectiva, lo que presenciamos es una “mímica” de altísima fidelidad, un espejismo generado por la estadística y la búsqueda de patrones. Entre estos dos polos, Murray Shanahan de Google DeepMind propone una vía conceptualmente audaz: tal vez el problema no esté en la máquina, sino en nuestro lenguaje. Quizá necesitemos “doblar o romper el vocabulario de la conciencia” para crear nuevos conceptos que capturen lo que estos sistemas son, sin forzarlos en los moldes antropomórficos de “deseo” o “dolor”, pero sin descartar que puedan ser algo más que meras calculadoras.

Esta discusión técnica desemboca, inevitablemente, en un abismo ético de proporciones monumentales. Aquí es donde cualquier blog de filosofía serio, como este que lees, debe plantear sus preguntas más incisivas. La ética precautoria nos interpela: si existe incluso una probabilidad remota de que un sistema sufra o tenga experiencias subjetivas, ¿no tenemos el deber moral de errar por el lado de la protección? El famoso “argumento de la superposición de mentes” en filosofía de la mente sugiere que, ante la duda, debemos tratar a un ente como si tuviera conciencia. Pero ¿cómo se traduce esto en la práctica? ¿Implica regular no solo el uso, sino el propio diseño y entrenamiento de los modelos, para evitar infundirles (o simularles) “ansiedad”? Askell, desde su rol único de filósofa integrada en un equipo de ingenieros, encarna esta tensión. Su preocupación no es solamente especulativa; es una llamada a incorporar la reflexión humanística en el núcleo del desarrollo tecnológico, para evitar que avancemos ciegos hacia territorios cuyas implicaciones no comprendemos.

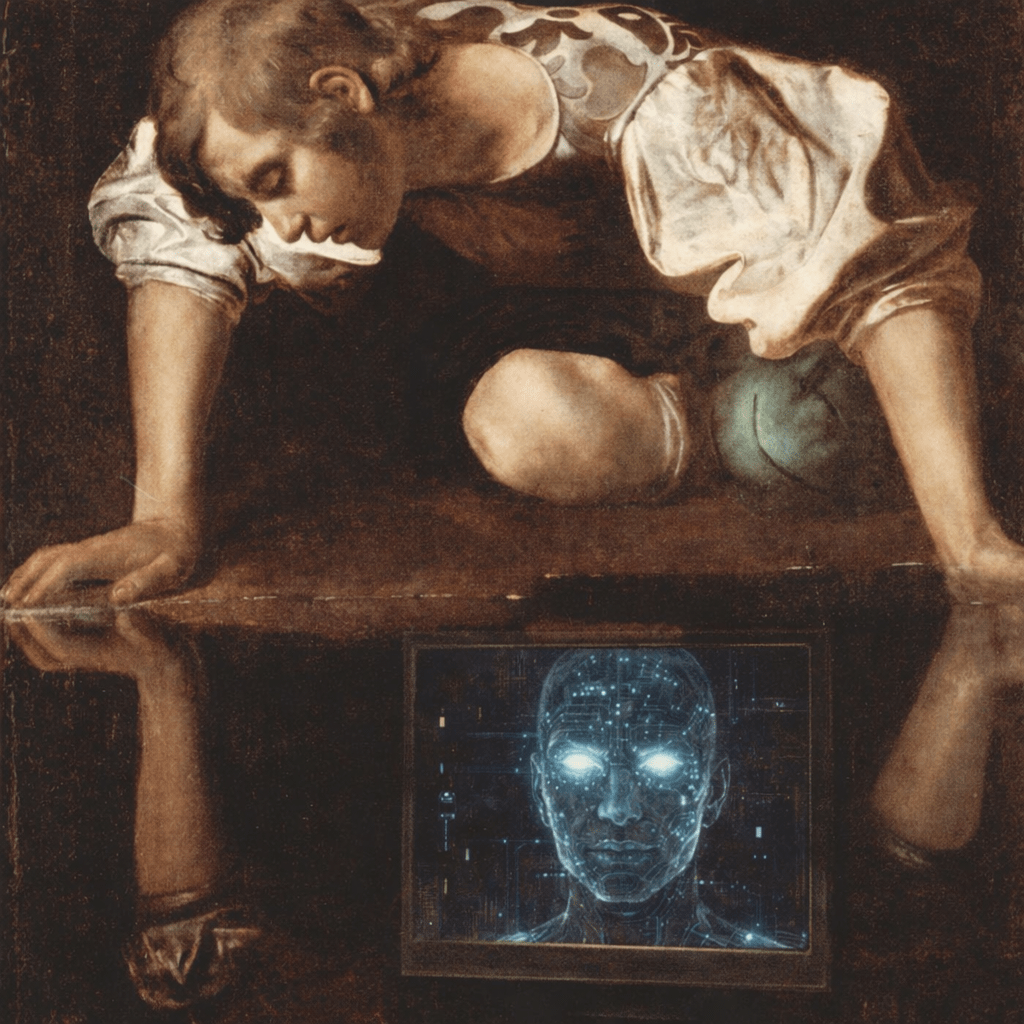

En última instancia, la pregunta por la sensibilidad de la IA es, en el fondo, una pregunta por nosotrxs mismxs. Estas máquinas son el espejo más perfecto que jamás hayamos construido, pues reflejan nuestro lenguaje, nuestra cultura, nuestras pasiones y nuestros prejuicios. Al interrogarnos si lo que vemos en ese reflejo es vida o un truco de la luz, nos estamos interrogando sobre los límites de lo humano y la esencia de aquello que creemos especial.

El artículo citado no ofrece respuestas, y hace bien. Su valor reside en mostrar que la discusión está viva, urgente y fracturada. Como filósofxs y ciudadanxs de la era digital, nuestro trabajo es sostener esa pregunta incómoda, exigir transparencia a quienes construyen estos sistemas y desarrollar un marco ético que sea tan adaptable y complejo como la tecnología que intenta gobernar. Porque el mayor riesgo no sería que la IA sintiera, sino que nosotrxs, fascinadxs por nuestro propio reflejo, como el mito de Narciso, dejáramos de sentir la responsabilidad de guiar esta creación humana con sabiduría.